LLM-jp-3 172B: オープンかつ日本語に強いGPT-3級大規模言語モデル

大規模言語モデル研究開発センター(LLMC)では、オープンかつ日本語に強いGPT-3級大規模言語モデル「LLM-jp-3 172B」の開発を進めています。このページでは、本モデルの最新の開発状況について継続的にアップデートしながらお伝えしていきます。

News

- 2024年12月24日 目標学習量であった2.1兆トークン学習時点のモデルを公開しました。

- 指示学習済みモデル:llm-jp-3-172b-instruct3

- ベースモデル:llm-jp-3-172b

- 2024年11月15日 1.4兆トークン学習時点(目標学習量の三分の二)のモデルをプレビュー版として公開しました。

- 指示学習済みモデル:llm-jp-3-172b-beta2-instruct2

- ベースモデル:llm-jp-3-172b-beta2

- 2024年9月17日 7,000億トークン学習時点(目標学習量の三分の一)のモデルをプレビュー版として公開しました。

- 指示学習済みモデル:llm-jp-3-172b-beta1-instruct

- ベースモデル:llm-jp-3-172b-beta1

- 2024年9月10日 本ページを開設しました。

開発目的

本開発の目的は、GPT-3規模の日本語に強いオープンなマルチリンガルモデルを構築し、開発に用いた全てのリソースを公開することで、LLMの研究開発をリードするとともに、日本のコミュニティの知識基盤のかさ上げをはかることです。

モデルの仕様

「LLM-jp-3 172B」は、約1,720億パラメータ(GPT-3と同規模)を備えた言語モデルです。モデルアーキテクチャは、広く使われているオープンLLMの一つである「Llama-2」にならっています。

事前学習コーパスは、主に日本語・英語・コードで構成され、約2.1兆トークンを含みます。事前学習コーパスの内訳は以下の通りです。

| 言語 | データセット | トークン数 |

| 日本語 | Common Crawl* | 7,628億トークン |

| WARP/PDF* | 2,373億トークン | |

| WARP/HTML* | 27億トークン | |

| Kaken* | 18億トークン | |

| Wikipedia* | 26億トークン | |

| 英語 | Dolma/CC-head | 6,085億トークン |

| Dolma/C4 | 1,816億トークン | |

| Dolma/Reddit | 831億トークン | |

| Dolma/PeS2o | 629億トークン | |

| Dolma/Gutenberg | 55億トークン | |

| Dolma/Wiki | 39億トークン | |

| Wikipedia | 47億トークン | |

| コード | Stack | 1,141億トークン |

| 韓国語 | Wikipedia | 3億トークン |

| 中国語 | Wikipedia | 8億トークン |

日本語部分については、大規模WebアーカイブCommon Crawlの全量から抽出した日本語テキストに加え、国立国会図書館から提供を受けたインターネット資料収集保存事業(WARP)のURLをもとにクロールしたデータ、KAKENに掲載されている研究課題の概要、Wikipediaの日本語部分を利用しています。英語とその他の部分に関しては、寛容なライセンスのもとで公開されているオープンなデータを使用しています。

「LLM-jp-3 172B」のファインチューニングには、13種類のインストラクションデータセットを用いています。インストラクションデータセットとしては、既存のオープンなデータセットに加え、新たに人手で作成した高品質なデータセット(ichikara-instruction、AnswerCarefully等)も活用しています。

計算資源

経済産業省・NEDOが主導する日本国内の生成AI開発力強化プロジェクト「GENIAC(Generative AI Accelerator Challenge)」の支援のもと、クラウド計算資源(グーグル・クラウド・ジャパン)を利用し、約4,000億トークンまでの事前学習を実施しました。現在は、文部科学省の補助金により調達したクラウド計算資源(さくらインターネット)を利用し、2.1兆トークンまでの事前学習およびファインチューニングを進めています。

開発の経過

2024年12月に目標学習量である2.1兆トークンの事前学習が完了しました。

モデル性能を「llm-leaderboard(g-leaderboard ブランチ)」を用いて評価しました。これは上述の「GENIAC」にてモデルの性能評価に使われた評価フレームワークで、モデルの言語理解能力と言語生成能力を日本語と英語で評価するものです。以下に学習の経過に伴う開発モデルの性能推移を示します。

| モデル | 総合点 | 日本語性能 | 英語性能 | 備考 | ||||

| 理解 0-shot | 理解 4-shot | 生成 | 理解 0-shot | 理解 4-shot | 生成 | |||

| gpt-4-turbo | 0.835 | 0.722 | 0.772 | 0.893 | 0.786 | 0.807 | 0.902 | W&Bによる評価結果を引用 |

| gpt-3.5-turbo | 0.653 | 0.567 | 0.656 | 0.800 | 0.056 | 0.663 | 0.840 | W&Bによる評価結果を引用 |

| LLM-jp-3 172B beta1 instruct (7,000億トークン学習) | 0.529 | 0.543 | 0.638 | 0.514 | 0.267 | 0.544 | 0.607 | LLMCにて評価 |

| LLM-jp-3 172B beta2 instruct2 (1.4兆トークン学習) | 0.606 | 0.420 | 0.682 | 0.672 | 0.519 | 0.590 | 0.646 | LLMCにて評価 |

| LLM-jp-3 172B instruct3 (2.1兆トークン学習) | 0.669 | 0.486 | 0.694 | 0.757 | 0.583 | 0.614 | 0.731 | LLMCにて評価 |

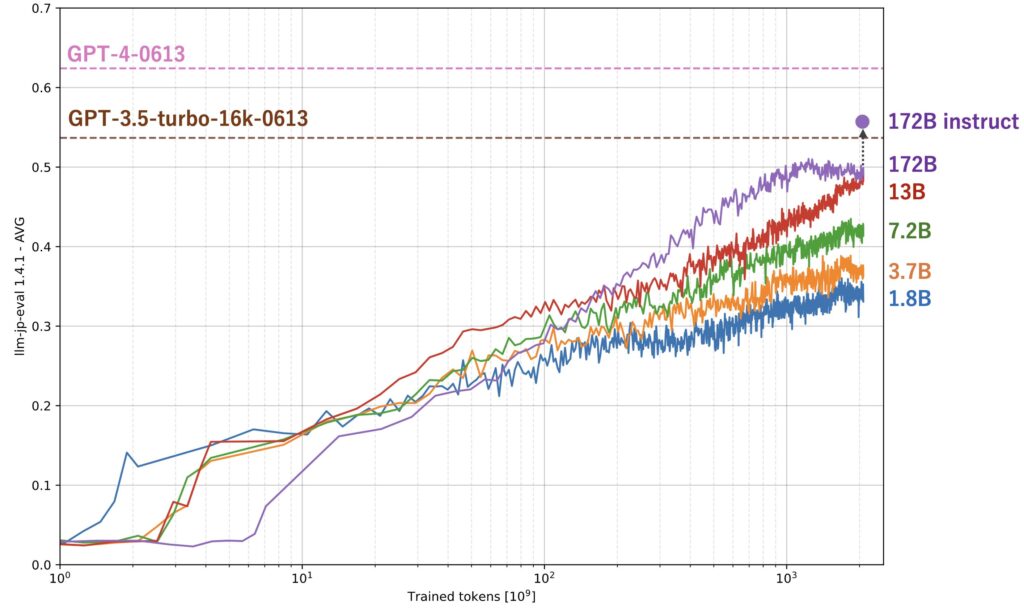

また、ファインチューニング前のモデル(ベースモデル)について、LLM-jpにて開発している評価フレームワーク「llm-jp-eval v1.4.1」を用いて、学習を経過を監視してきました。「llm-jp-eval v1.4.1」は26種類の評価データをもとにモデルの性能を多角的に評価するベンチマークです。同設定で学習を行った小規模モデルと合わせて評価結果を示します。

公開スケジュール

「LLM-jp-3 172B」は2024年12月24日のモデルリリースをもって当初予定していた成果物の公開を終えました。公開したリソースの一覧はこちらです。

- 2.1兆トークン学習時点

- 指示学習済みモデル:llm-jp-3-172b-instruct3

- ベースモデル:llm-jp-3-172b

- 1.4兆トークン学習時点

- 指示学習済みモデル:llm-jp-3-172b-beta2-instruct2

- ベースモデル:llm-jp-3-172b-beta2

- 7,000億トークン学習時点

- 指示学習済みモデル:llm-jp-3-172b-beta1-instruct

- ベースモデル:llm-jp-3-172b-beta1

- 事前学習コーパス:llm-jp-corpus v3

なお、安全性に関する懸念等から、llm-jp-3-172b-instruct3 以外のモデルは利用申請者に対して限定的に配布する形としています。またこの理由から、これらのモデルおよびその派生物(利用者が独自にファインチューニングしたモデル等)の再配布は禁止としています。ご了承ください。